Per molti anni, soprattutto gli ultimi due decenni, l’efficienza nella protezione dei dati veniva associata alla deduplicazione, ma ora sarebbe opportuno iniziare a rivalutare ciò che fino a poco tempo fa eravamo abituati a definire efficiente per quanto riguarda la protezione dei dati. Nel valutare la “dimensione dei blocchi di deduplicazione” e la “deduplicazione di origine e destinazione” si è smesso di considerare gli aspetti più importanti, ovvero la riduzione dei costi di elaborazione, archiviazione e rete. Detto questo è semplice vedere gli effetti di quanto abbiamo appena affermato, troviamo spesso aziende con sistemi di deduplicazione che sono sottoutilizzati, hanno tre o più copie di dati complete e spesso le reti sovraccariche.

Con l’evoluzione del cloud, e il sempre più marcato passaggio a questo tipo di tecnologia, le architetture tradizionali di protezione dei dati non riescono a stare al passo con il passaggio delle aziende al cloud; carichi di lavoro distribuiti in più località, norme in continua evoluzione e minacce informatiche sempre più evolute e difficili da contenere obbligano le aziende a lavorare in maniera molto maggiore per tentare di tenere il passo con l’evoluzione tecnologica nell’ambito di protezione dei dati.

Il Data Protection as a Service (DPaaS) ha un obiettivo ben chiaro: lavorare al meglio per dare la migliore protezione dei dati possibile. Fatte queste premesse di seguito affronteremo il tema dell’efficienza della protezione e il motivo per cui questa è cambiata, vedremo le inefficienze delle architetture legacy nel cloud e i requisiti di oggi per migliorare l’efficienza nella protezione dei dati.

Oggi l’efficienza è cambiata: perché?

Il passaggio al cloud ha cambiato il modo in cui misuriamo l’efficienza, perché né i carichi di lavoro di produzione né la soluzione di protezione sono più confinati al solo data center. Oggi abbiamo bisogno di avere una maggiore efficienza della rete per poter proteggere i dati che risiedono al di fuori del “confine” aziendale, nelle applicazioni SaaS , nel cloud pubblico e nel data center .

Avendo i dati dislocati in posizioni che non possono supportare un’appliance di backup, converrete con noi che l’unico approccio oggi è una soluzione di protezione centralizzata. Mentre nel data center la larghezza di banda della rete era praticamente onnipresente, oggi, con uffici remoti, smart working, applicazioni SaaS e una forza lavoro distribuita, l’efficienza della rete è diventata un requisito fondamentale.

Tradizionalmente l’IT esegue il provisioning eccessivo delle appliance di backup per gestire il picco di carico durante la finestra di backup, mentre i sistemi sono inattivi per tutto il giorno. La situazione è ancora peggio se pensiamo che, per espandere le appliance di backup iperconvergenti, i clienti devono acquistare più risorse di elaborazione e storage, anche se hanno bisogno di un solo tipo di risorsa.

Il mercato ormai ha accettato questa inefficienza, perché le appliance hardware on-premise non possono scalare su richiesta, ma il cloud può. Il cloud è la piattaforma ideale per la moderna protezione dei dati perché scala on-demand, ridimensiona il calcolo e lo storage in modo indipendente e offre le opzioni di storage più economiche. Grazie al cloud, l’efficienza non viene più misurata a livello di appliance, ma viene misurata dalle vere risorse principali: rete, elaborazione e storage.

Perché la protezione dei dati legacy nel cloud è inefficiente

Ormai ogni fornitore riconosce il valore del cloud, per questo motivo oggi tutti hanno offerte cloud, tuttavia molti fornitori di servizi utilizzano il cloud in modo totalmente inefficiente, in quanto la prassi comune è quella di sollevare e spostare le architetture legacy sul cloud, senza invece rivedere la configurazione e l’utilizzazione dei sistemi in ottica di cloud, per sfruttarne appieno le potenzialità e l’efficienza.

Vediamo assieme quali sono alcuni approcci inefficienti:

- Livelli di conservazione cloud che duplicano i dati: la “copia cloud” per la conservazione a lungo termine è una copia separata che non viene deduplicata con i backup attivi. Le aziende ora hanno una seconda copia dei loro dati, l’opposto della deduplicazione.

- L’air-gapped ransomware copia i dati duplicati e incorre in rischi: la creazione di una copia air-gapped ransomware duplica i dati. Poiché è separata dalla copia di conservazione, è la terza copia di backup.

Ancora peggio, poiché i dati sono ancora nell’account del cliente, rimangono vulnerabili agli attacchi ransomware. - Le appliance virtuali sprecano capacità di calcolo della CPU e utilizzano storage costoso: le “appliance virtuali” in cloud consumano istanze di calcolo costose e storage a blocchi 24 ore al giorno. Come le appliance on-premise, le appliance virtuali non possono aumentare o diminuire dinamicamente, quindi è comunque necessario eseguire il provisioning per il loro massimo utilizzo. La differenza dalle appliance locali è che ora si sta pagando per avere la flessibilità del cloud che non si sta utilizzando.

Credo siamo tutti consapevoli che il cloud è il futuro della protezione dei dati, ma se viene utilizzato in modo improprio può risultare ancora più inefficiente rispetto alle appliance legacy. Una soluzione efficiente per la protezione dei dati deve essere espressamente progettata per il cloud e non ci si dovrebbe limitare ad adattare una soluzione legacy.

Vediamo alcuni requisiti di efficienza del cloud

Dopo aver visto gli approcci inefficienti più comuni, legati alla protezione dei dati in cloud, possiamo sottolineare che una soluzione efficiente deve ottimizzare il consumo di risorse di rete, elaborazione e archiviazione, per ridurre al minimo i costi e la complessità per i clienti.

Vediamo quindi alcuni punti:

- Deduplicazione globale basata sull’origine (archiviazione e rete): la deduplicazione tradizionale è limitata a un singolo dispositivo o cluster, ma nel cloud dovrebbe scalare a livello globale per ottenere il massimo risparmio di spazio. La deduplica globale basata sull’origine consente di ottenere la massima efficienza della larghezza di banda, fondamentale per gli uffici remoti, gli endpoint e le applicazioni perimetrali.

- Deduplicazione su più livelli di dati (storage): la deduplicazione dovrebbe estendersi su più livelli di storage, di conseguenza una soluzione di protezione non ha bisogno di creare una copia completa dei dati solo per utilizzare il cold storage.

I clienti dovrebbero risparmiare immediatamente denaro sfruttando il cold storage e non pagare di più per archiviare una copia aggiuntiva. - Protezione ransomware integrata (archiviazione): le soluzioni di protezione in cloud dovrebbero archiviare automaticamente i backup fuori sede in un account separato, eliminando la necessità di un’altra copia del backup.

- Scalabilità on-demand (calcolo): le soluzioni di protezione in cloud devono essere scalabili verso l’alto e verso il basso, quindi non è necessario un overprovisioning.

La soluzione fornisce prestazioni ed efficienza allocando e liberando automaticamente le risorse per soddisfare le esigenze di prestazioni dei clienti. - Scalabilità indipendente (calcolo e archiviazione): le soluzioni di protezione in cloud dovrebbero scalare le capacità di elaborazione e archiviazione in modo indipendente, in modo che i clienti possano ottenere le prestazioni e la conservazione dei dati di cui hanno bisogno, senza arrivare ad aumentare i costi.

- Ripristino flessibile (rete)

- Le soluzioni efficienti supportano le opzioni di rete ad alte prestazioni per il cloud, ad esempio la connessione diretta con partner come Equinix.

- I clienti dovrebbero essere in grado di eseguire il ripristino dal cloud in locale tramite strumenti come AWS Snowball.

- I clienti dovrebbero essere in grado di ripristinare i dati nel cloud o in locale, per consentire la massima efficienza della larghezza di banda.

Una soluzione di protezione dei dati nativa per il cloud ha un’architettura fondamentalmente diversa rispetto a un’appliance di protezione dei dati e la differenza di efficienza è lo strumento di valutazione più semplice per stabilire quale si sta valutando.

Conclusione

Dopo svariati confronti negli anni sull’efficienza della deduplicazione dei dispositivi di backup, possiamo essere tutti d’accordo nell’affermare che il mercato ormai è cambiato. I dispositivi di backup attuali non sono efficienti per ambienti dati distribuiti, conservazione a lungo termine, protezione ransomware, ambienti dinamici e ripristino rapido.

Il cloud fornisce una architettura del tutto nuova, che sta cambiando il modo in cui valutiamo l’efficienza della protezione incentrata sullo storage principale, sull’elaborazione e sulle risorse di rete. Sfortunatamente, le architetture legacy non sono in grado di sfruttare la flessibilità, la scalabilità, la connettività di rete e le opzioni di archiviazione a basso costo del cloud.

E opportuno iniziare a ottenere una maggiore efficienza dalla propria soluzione di protezione dei dati basata su cloud. Richiedere la deduplica globale basata sull’origine, la suddivisione in livelli compatibile con la deduplicazione, la protezione ransomware nativa, la scalabilità su richiesta, la scalabilità indipendente e opzioni di ripristino flessibili.

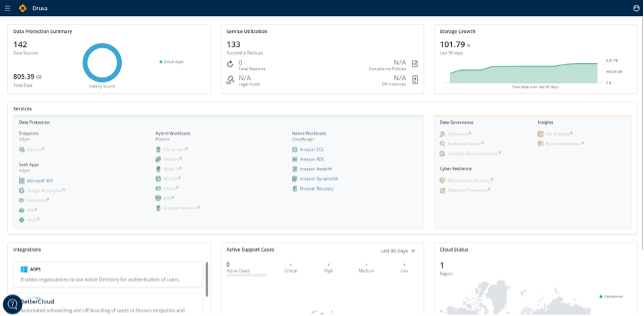

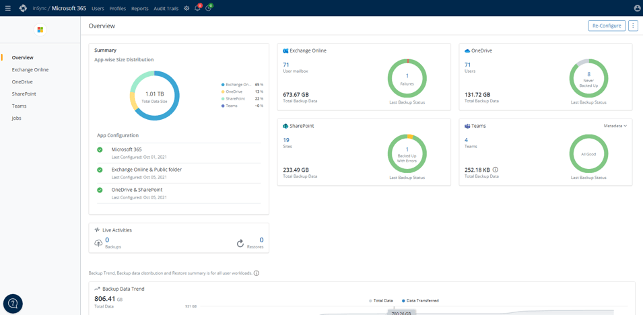

Se si vuole iniziare ad avere una vera efficienza del cloud, Druva è lo standard con cui tutte le altre soluzioni si confrontano.